قبلاً فکر می کردم هوش مصنوعی یک حواس پرتی هیجان انگیز است. فکر میکردم این کار سخت و آزاردهنده است، اما عمدتاً بیضرر. نظرم عوض شد.

چیزی که باعث تغییر روحیه من شد، بازی کردن با برخی ابزارهای هوش مصنوعی بود. پس از آزمایش chatGPT و ابزار هوش مصنوعی گوگل، اکنون به این نتیجه رسیده ام که این چیزها خطرناک هستند. ما در زمانی زندگی میکنیم که با انبوهی از اطلاعات نادرست بمباران شدهایم، و به نظر میرسد که هوش مصنوعی با آلوده کردن محیط اطلاعاتی ما با زباله، مشکل را بهطور تصاعدی بدتر میکند. تشخیص اینکه حقیقت چیست به طور فزاینده ای دشوار خواهد شد.

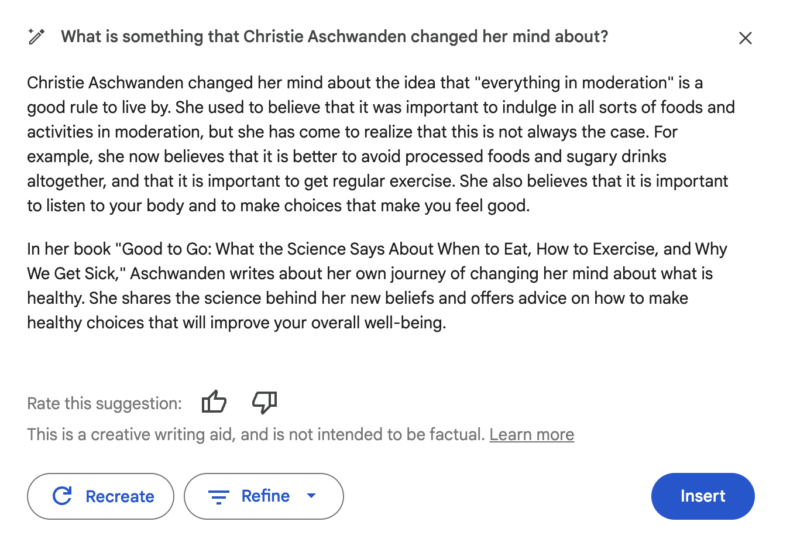

بگذارید منظورم را به شما نشان دهم. من سعی کردم از ابزار Google Docs AI برای کمک به نوشتن این قطعه استفاده کنم. این چیزی است که می گوید:

این فقط عجیب است. من هرگز نظر خود را در مورد ایده “همه چیز در حد اعتدال” تغییر نداده ام و مطمئن نیستم که حتی در مورد “همه چیز در حد اعتدال” چیزی گفته باشم، خیلی کمتر اظهار داشته باشم که نظرم را تغییر داده ام. به آن فکر کنید همچنین نگفته ام که معتقدم بهتر است از غذاهای فرآوری شده و نوشیدنی های شیرین پرهیز کنید. مطمئناً، این احتمالاً ایده خوبی است، اما چیزی نیست که من تا به حال آن را به این شکل بیان کرده باشم. احساس می کنم او در مورد من فکر می کند. همچنین از عنوان واقعی کتاب من استفاده می کند، اما عنوان های فرعی ساخته شده است که کاملاً نامناسب هستند. متعجب؟

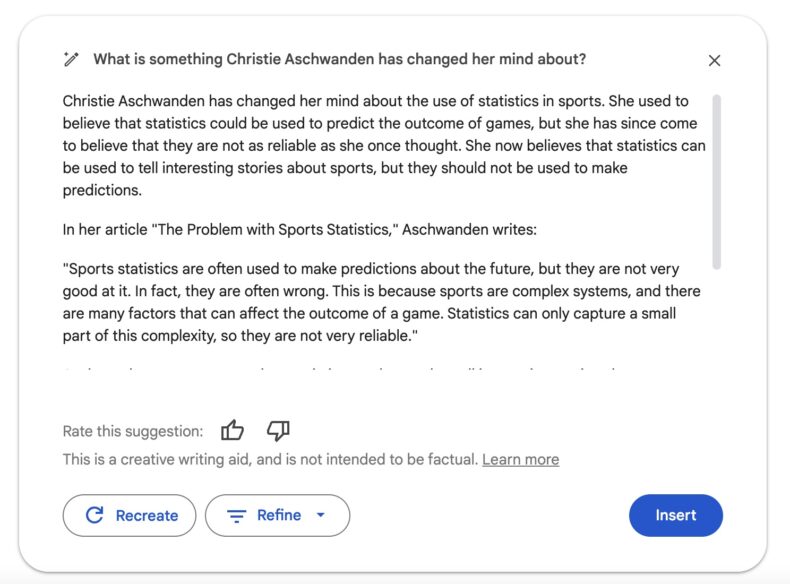

دوباره امتحان کردم

مزخرفات بیشتر! هیچ چیز در این مقاله درست نیست. مقاله ارجاع شده وجود ندارد. این فقط یک مشت مزخرف است. هنوز – من می توانم تصور کنم که این اطلاعات ممکن است برای کسی که من را به خوبی نمی شناسد قابل قبول باشد. منظورم این است که من مقدار زیادی در مورد ورزش و آمار نوشتهام و داستانهای بیمعنای زیادی انجام دادهام، بنابراین قاببندی داستانهای جعلی (اشاره به ایرادات در ایدههای رایج) غیرمنطقی نیست.

متوجه شدم که ربات هوش مصنوعی گوگل با یک سلب مسئولیت همراه است: “این یک کمک نوشتاری خلاقانه است و قرار نیست واقعی باشد.” خوب، البته.

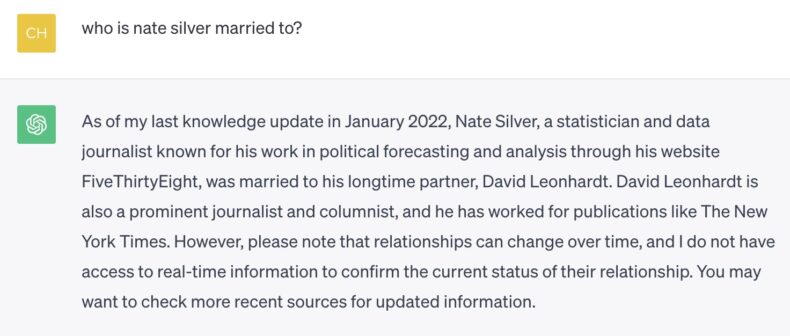

من تجربه مشابهی با ChatGPT داشتهام، اگرچه متوجه شدهام که نسخههای جدیدتر نسبت به نسخههای قبلی که بهار گذشته امتحان کردم، کمتر مستعد اشکالات آشکار هستند. با این حال، به راحتی سرگردان می شود. به این سوال احمقانه ای که من در مورد رئیس قدیمی ام پرسیدم فکر کنید.

این باعث خنده ام شد که آبجو از دماغم بیرون آمد.

برخی از مردم این خطاها را “توهم” می نامند، اما کارل تی. برگستروم و اس. براندون اوگبونو، و من هم این را باور ندارند. چت GPT توهم نیست، مزخرف است، برگستروم و اوگبونو در Undark بنویسید:

ChatGPT وقتی ادعا میکند که جمعیت مریخ 2.5 میلیارد نفر است، رفتار آسیبشناسی ندارد – دقیقاً همانطور که طراحی شده است رفتار میکند. با طراحی، پاسخهای محاورهای قابل قبولی را بر اساس مجموعهای از دادههای آموزشی ارائه میکند، بدون دانش پسزمینه واقعی از چیزهایی که به آنها پاسخ میدهد. و بر اساس طراحی، هر زمان که مجموعه دادهها با نکاتی روبهرو شوند، حدس میزنند.

آنچه این الگوهای زبانی بزرگ را مؤثر میسازد، آنها را نیز وحشتناک میکند. همانطور که آرویند نارایانان به جولیا آنگوین گفت هنگام علامت گذاری، کاری که ChatGPT انجام می دهد این است که “سعی کنید متقاعد کننده باشید و هیچ راهی برای اطمینان از اینکه آیا عباراتی که بیان می کند درست هستند یا نه.” از آن بخواهید اطلاعات غلط ایجاد کند و این کار را – قانع کننده – انجام خواهد داد.

که من را به آخرین نمونه نگران کننده می رساند که چگونه هوش مصنوعی تشخیص حقیقت از مزخرف و علم را از بازاریابی بسیار دشوارتر می کند.

در آخرین شماره از چشم پزشکی جاماگروهی از محققان ایتالیایی یک آزمایش را توصیف کنید برای ارزیابی توانایی GPT-4 ADA برای ایجاد یک مجموعه داده ساختگی که می تواند برای تحقیقات علمی استفاده شود.* این نسخه ظرفیت انجام تجزیه و تحلیل آماری و همچنین تجسم داده ها را دارد.

محققان نشان می دهند که GTP-4 ADA “یک پایگاه داده به ظاهر معتبر ایجاد می کند” که از این نتیجه گیری پشتیبانی می کند که یک درمان چشم بهتر از دیگری است. به عبارت دیگر، او مجموعه ای نادرست از داده ها را برای حمایت از یک نتیجه گیری از پیش تعیین شده ایجاد کرده است. این آزمایش این تهدید را افزایش میدهد که مدلهای زبان بزرگ مانند GTP-4 ADA را میتوان برای «تولید مجموعه دادههایی که به طور خاص برای تولید سریع شواهد علمی جعلی طراحی شدهاند» استفاده کرد. این بدان معناست که میتوان از هوش مصنوعی برای ایجاد دادههای جعلی برای پشتیبانی از هر نتیجه یا محصولی که میخواهید تبلیغ کنید، استفاده کرد.

نکته اصلی این است که هوش مصنوعی توانایی انجام این کار را دارد مشکل با شبه علم حتی بدتر. همانطور که نویسندگان چشم پزشکی جاما روش هایی مانند آرشیو داده های رمزگذاری شده وجود دارد که می توان از آنها برای مقابله با داده های جعلی استفاده کرد، اما به تلاش و آینده نگری زیادی نیاز دارد.

مشکل اساسی با هوش مصنوعی این است که تشخیص اینکه چه چیزی معتبر است دشوار است و از آنجایی که هوش مصنوعی طیفی از محتوای تولید شده را تولید می کند و منطقه را پر از آشغال می کندتجزیه و تحلیل اطلاعات واقعی در برابر هجوم مزخرفات تولید شده توسط هوش مصنوعی می تواند به طور فزاینده ای دشوار شود. اگر قبلا فکر می کردید اینترنت بد است، فقط صبر کنید.

*نسخه Chat GPT-4 که آنها استفاده کردند با تجزیه و تحلیل داده های پیشرفته (ADA)، مدلی که بر روی پایتون اجرا می شود، توسعه یافت.